Qualcomm пошла войной на Nvidia: придумано «железо», которое ускорит искусственный интеллект в 10 раз

Корпорация Qualcomm разработала ускоритель для ЦОДов, призванный улучшить вычисления в сфере искусственного интеллекта. Рынок решения в данной области к 2025 г. вырастет до $17 млн. Сейчас основным поставщиком на нем является Nvidia.Qualcomm поможет работать с искусственным интеллектом в облаках

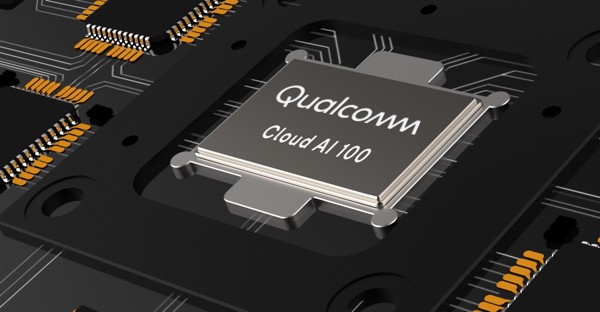

Корпорация Qualcomm представила аппаратный ускоритель для ЦОДов, призванный улучшить вычисления в области искусственного интеллекта – Cloud AI 100. Презентация состоялась на прошедшем в Сан-Франциско ежегодном Дне искусственного интеллекта.

Сейчас задача ускорения вычислений для искусственного интеллекта в ЦОДах решается за счет различных устройств: графических процессоров (GPU), программируемых пользователем вентильных матриц (FPGA) и интегральных схем специального назначения (ASIC).

Графические процессоры и FPGA позволяют увеличить эффективность расчетов, связанных с искусственным интеллектом, в десять раз. В то же время в Qulacomm утверждает, что их решение, будучи изначально спроектированным под соответствующие нужды, повышает эффективность расчетов еще в десять раз.

При разработке Cloud A1 100 в Qualcomm использовали существующие наработки в области платформ для мобильных устройств – Snapdragon – в том числе в части энергоэффективности. При этом в корпорации подчеркивают, что представленное решение было разработано с нуля, а не является доработкой Snapdragon.

Производительность Cloud A1 100 в части искусственного интеллекта в 50 раз больше производительности Snapdragon 8250 и примерно в 15-20 раз больше производительности Snapdgaron 855. Показатель TOPS (тераопераций в секунду) у Cloud A1 100 будет значительно превышать 100.

Навстречу туманным вычислениям

Cloud A1 100 будет использоваться в облачных и периферийных вычислениях. Периферийные вычисления (edge computing) – следующий шаг в развитии облачных вычислений, ориентированный на сферу интернета вещей. В этой парадигме большой объем данных с различных устройств интернета вещей обрабатывается не центральным сервером, а промежуточными серверами, расположенными по периметру сети – то есть ближе к источникам данных.

В нынешних условиях различного рода данные – видео, голос, изображения, информация от датчиков и сенсоров – поступают на периферийные устройства (компьютеры, телефоны, автомобили, очки виртуальной реальности и т.д.), а затем по сетям 3G и 4G передаются для обработки на центральные сервера. В связи с этим возникает необходимость в сокращении задержек с передачей данных.

Это проблему можно будет решить за счет изменения среды передачи данных на 5G и появлению промежуточных вычислительных узлов между пользовательскими устройствами и традиционным облаком.

Cloud A1 100 будет выполнен в различных форм-факторах под нужды разных заказчиков. Чип создан на базе процессора, выполненного по технологии 7 нм. Cloud A1 100 обеспечит обработку данных в сфере агрегации новостей, развлечений, персонального видео, поиска, виртуальной и дополненной реальности и игр.

Среды и инструменты разработки для Cloud A1 100

Для разработчиков Cloud A1 100 будет иметь целый набор инструментов: компиляторы, дебагеры, шифраторы, мониторы и пр. Также поддерживают различные среды разработки: Glow, ONX и XLA.

Кроме того, заявлена поддержка различных шаблонов обучения: Google TensorFlow, Facebook PyTorch, Keras, XNet, Baidu PaddlePaddle и Microsoft Cognitive Toolkit .

С кем предстоит конкурировать Qualcomm

По оценкам Qualcomm, рынок решений для обработки данных в ЦОД с помощью решений искусственного интеллекта вырастет с $2 млрд в 2018 г. до $17 млрд в 2025 г. Правда, самому Qualcomm придется место на этом рынке отвоевывать, отмечает издание Venture Beat.

Сейчас в сфере обработки данных с применением искусственного интеллекта лидеров является корпорация Nvidia с ее графическими процессорами. Также ряд решений представила корпорация Intel. Это Nervana Nvbeural Network Processor (NNP-I), производительность которого в части искусственного интеллекта, согласно обещаниям, в 10 раньше больше, чем у графических карт. Также корпорация представила свою линейку FPGA для искусственного интеллекта – Agilex.

В области FPGA свои решения также представили такие гиганты, как Amazon, Microsoft и Facebook: AWS Inferentia, Project Brainwave и Kings Canyon. Со своей стороны, корпорация Google представила собственный ASIC для работы в сфере искусственного интеллекта – Edge TPU.

Поделиться

Поделиться