Nvidia выпустила революционный ИИ-суперчип для моделей машинного обучения с триллионами параметров

Nvidia выпустила «самый мощный ИИ-чип в мире», а также «суперчип» и несколько модульных систем на его основе. Новинки предназначены для построения инфраструктуры, которая способна «гонять» модели машинного обучения с триллионами параметров и расходовать в процессе в разы меньше электроэнергии, нежели предшественники семейства Hopper.Новый чип Nvidia

Корпорация Nvidia представила новые ускорителей вычислений на базе архитектуры Blackwell, которая пришла на смену Hopper, анонсированной в марте 2022 г.

Чип позиционируется как основа для построения высокопроизводительных систем, предназначенных для обучения и инференса гигантских моделей – с триллионами параметров. Столь сложные модели могут использоваться при решении задач, связанных с обработкой естественного языка (NLP), созданием мультимодальных приложений (совмещают в себе функции генерации видео, текста и звука), кодогенерации и др.

Архитектура названа в честь Дэвида Блэквелла (David Blackwell) – американского ученого, специализировавшегося на математике и статистике.

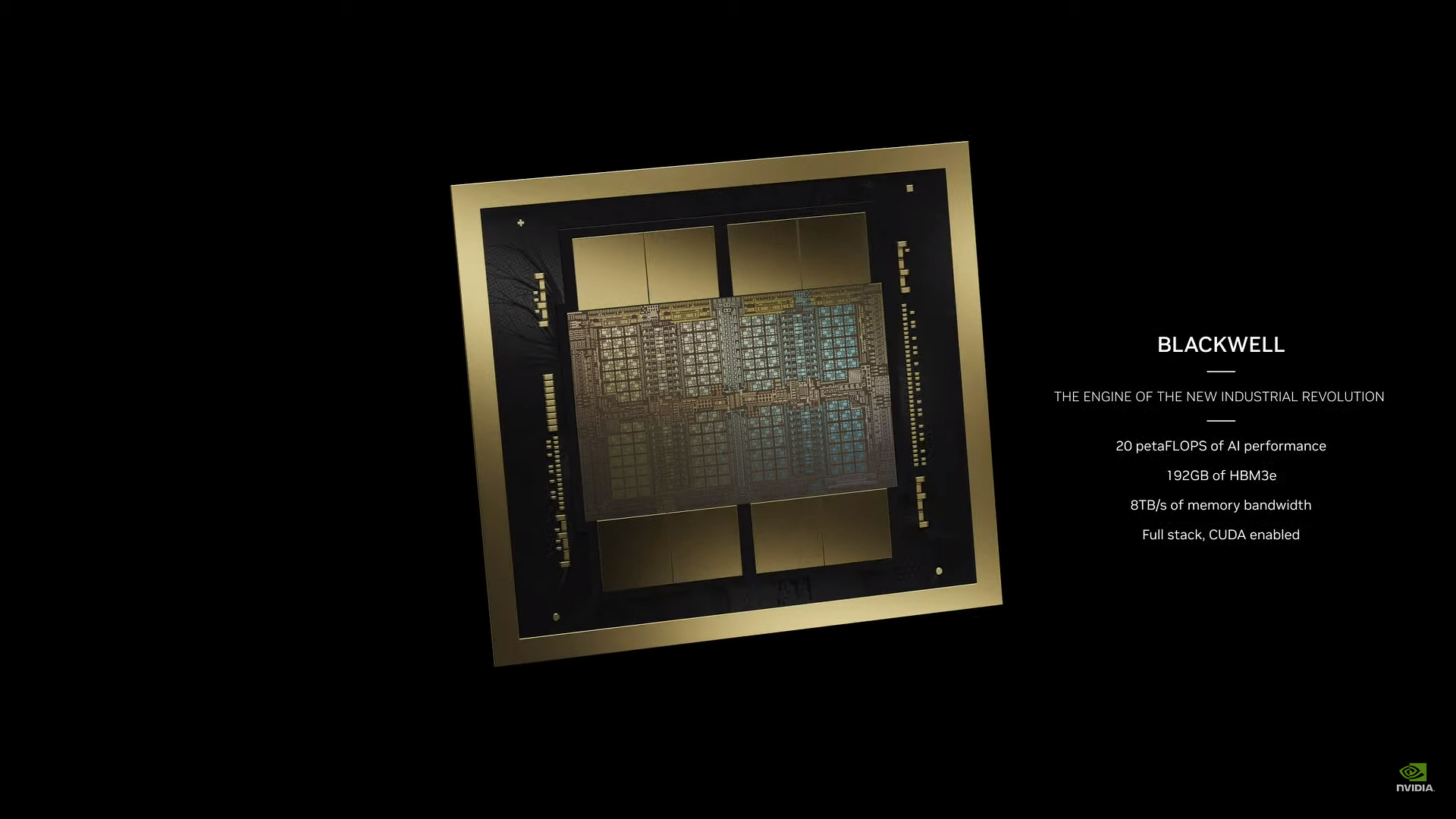

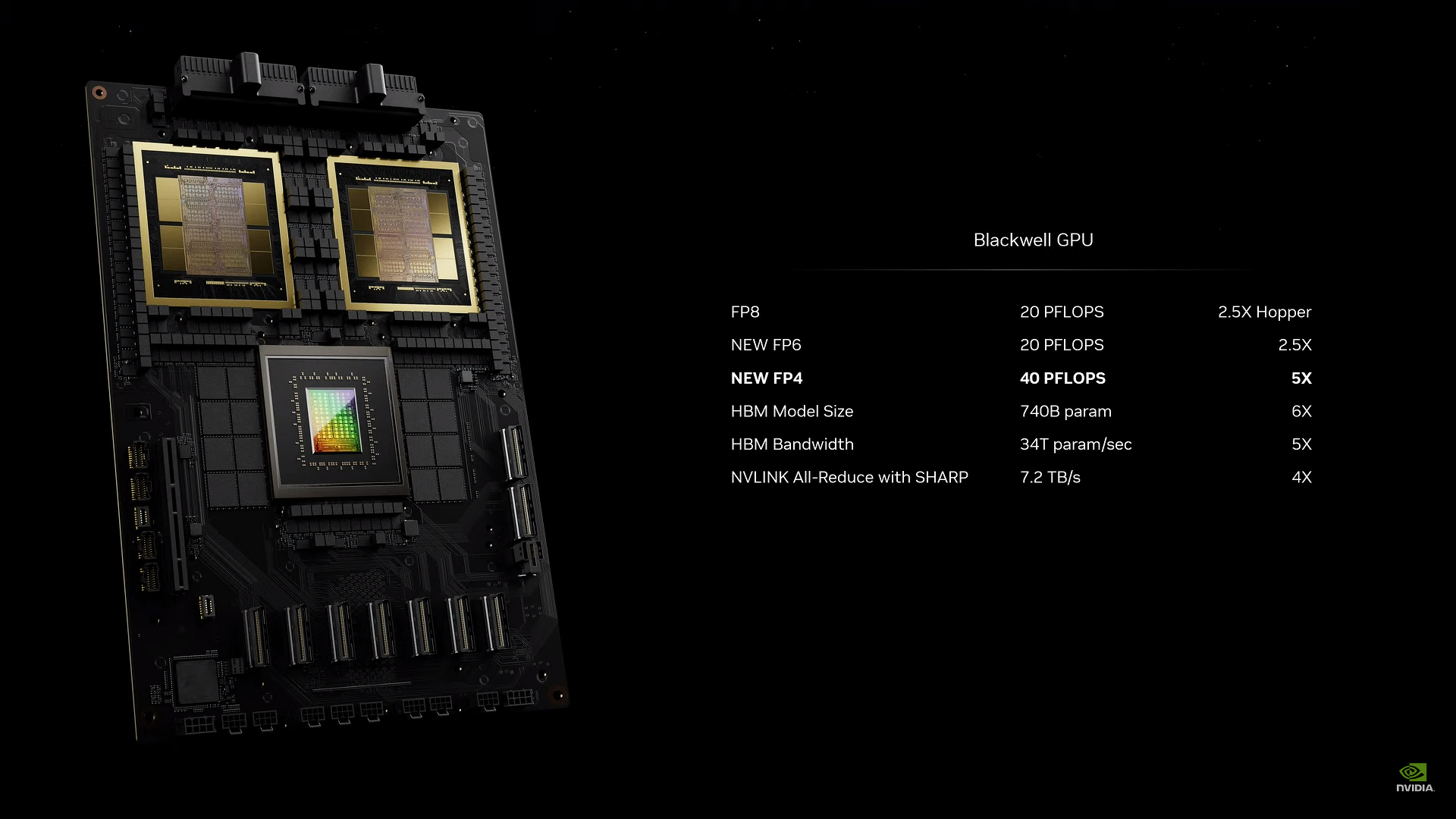

Новый GPU B200, наследник крайне востребованных на рынке H100/H200, выполнен по 4-нанометровому технологическому процессу TSMC и несет 208 млрд транзисторов (H100, к примеру, имеет лишь 80 млрд), которые обеспечивают ему производительность на уровне 20 Пфлопс (FP4). В Nvidia чип называют «самым мощным в мире» и «двигателем для новой промышленной революции».

Как утверждают в компании, системы на основе архитектуры Blackwell способны решать те же задачи, что и базирующиеся на Hopper (H100), но вплоть до 25 раз с более высокой энергоэффективностью и помогают сократить затраты на приобретение оборудования и электроэнергии. Так, согласно приведенным компанией данным, обучение модели с 1,8 трлн параметров ранее потребовало бы 8 тыс. GPU семейства Hopper и 15 МВт мощности питания. GPU Blackwell якобы позволяют решить ту же самую задачу силами всего 2 тыс. ускорителей при 4 МВт.

Модули и готовые системы на основе B200

Помимо непосредственно графических процессоров B200, Nvidia предлагает готовые модули для построения и дальнейшего масштабирования ИИ-инфраструктуры на их основе.

Так, модуль GB200, который в Nvidia называют «суперчипом» на самом деле состоит из трех отдельных микросхем: двух GPU B200, а также центрального процессора Grace, который соединен с GPU шиной NVLink-C2C, обеспечивающей суммарную пропускную способность 900 ГБ/с. В то же время между собой чипы B200 связаны посредством шины NVLink 5 с пропускной способностью 1,8 ТБ/с. Процессор общего назначения Grace при этом имеет 72 Arm-ядра Neoverse V2 с 144 МБ кеша третьего уровня и LPDDR5x-памятью совокупной емкостью до 480 ГБ.

По данным Nvidia, в бенчмарке большой языковой модели GPT-3, содержащей 175 млрд параметров, GB200 демонстрирует производительность примерно в семь раз превышающую показатели H100.

В свою очередь на основе модулей GB200 Nvidia предлагает решения для высокопроизводительных вычислений, умещающееся в стандартную 19-дюймовую телекоммуникационную стойку – NVL72. GB200 NVL72 состоит из 36 CPU Grace и 72 GPU B200, объединенных при помощи девяти коммутаторов NVLink Switch. Система охлаждения – жидкостная. Два модуля GB200 или пара коммутаторов занимают 1U в стойке.

Производительность решения в инференсе модели (FP4) достигает 1,44 Эфлопс (1440 Пфлопс), в обучении (FP8) – 720 Пфлопс.

Компания также предлагает модульные серверы DGX Superpod на основе GB200, состоящие из восьми стоек NVL72 совокупной производительностью 11,5 Эфлопс: 288 CPU, 576 GPU и 240 ТБ высокоскоростной памяти HBM3E.

Возможности масштабирования

По заявлению Nvidia, одна система GB200 NVL72 способна обеспечить инференс модели с 27 трлн параметров. Как отмечает The Verge, большая языковая модель GPT-4, которую использует популярный чат-бот ChatGPT компании OpenAI, содержит 1,7 трлн параметров.

В Nvidia говорят о выдающихся возможностях масштабирования систем на основе «суперчипов» – якобы разработанная компанией архитектура позволяет объединять десятки тысяч устройств GB200 с использованием новейших 800-гигабитных коммутаторов Quantum-X800 InfiniBand (до 144 соединение) и Spectrum-X800 Ethernet (до 64 соединений), которые позиционируются как девайсы, специально разработанные для работы с гененеративными моделями.

Новый процессор для NVLink Switch

Nvidia также провела модернизацию коммутаторов NVLink Switch, обеспечивающих взаимодействие GPU посредством высокоскоростной шины NVLink. Теперь такое устройство дает возможность максимум 576 чипам обмениваться данными на скорости до 1,8 ТБ/с. Для этого инженерам компании пришлось создать новый сетевой чип с 50 млрд транзисторов, обеспечивающий производительность на уровне 3,6 Тфлопс (FP8).

Ранее кластер из 16 GPU Hopper 60% времени работы расходовал на коммуникацию с «соседями» и лишь 40% – на выполнение полезных вычислений, утверждают в Nvidia. Теперь часть нагрузки такого рода на себя возьмет новый процессор коммутатора NVLink Switch.

Облачные гиганты уже в очереди за новинками

Американские технологические гиганты, оказывающие услуги облачных вычислений, в лице Amazon, Google, Microsoft и Oracle планируют предоставлять мощности NVL72 своим клиентам, утверждают в Nvidia. Сколько таких машин готовы приобрести эти компании, не уточняется.

Поделиться

Поделиться