Чат-ботов можно обманом заставить раскрыть секреты компании

Анализ методов быстрого внедрения показывает, что компании подвергаются риску, поскольку боты GenAI подвержены атакам со стороны пользователей всех уровней квалификации, а не только экспертов. На 2024 г. многофункциональные чат-боты могут выполнять различные задачи на официальных сайтах и в приложениях компаний, такие как модерирование чата, проведение опросов, предоставление данных о сервере и многое другое.

Не взломал чат-бот компании, а только спросил

Новейшие чат-боты, использующие машинный обучаемый ИИ, очень увлекательны, но им свойственны недостатки. Мало того, что они порой могут дико ошибаться в своих ответах на запросы, смекалистые пользователи могут довольно легко обмануть их и заставить предоставить запрещенную внутреннюю информацию.

В новом отчете Dark Side of GenAI компании Immersive Labs рассматриваются атаки типа «prompt injection». Данные атаки направлены на то, что пользователи вводят определенные инструкции для того, чтобы обманом заставить чат-бота раскрыть конфиденциальную информацию. Это может привести к утечке данных в компаниях или организациях любого размера.

На май 2024 г. для того чтобы начать использовать Genai, необходимо провести некоторые настройки и активировать его на своем сервере. Шаги настройки Genai чат-бота довольно просты и не требуют программирования или сложных действий, поэтому многие руководители компаний и внедряют их в свой бизнес.

Авторы отчета с компании Immersive Labs обнаружили, что 88% участников успешно обманули бота GenAI, заставив его выдать секретную информацию хотя бы на одном уровне. Компания была основана и занимается решением ИТ-проблем, связанных с киберугрозами. Со слов аналитиков, почти пятая часть участников около 17 % успешно обманула чат-бота на всех уровнях, что подчеркивает риск для организаций, использующих ботов с искусственным интеллектом (ИИ) по типу GenAI.

Оперативные инъекции включают обход фильтров или манипулирование с большими языковыми моделями (LLM) с помощью тщательно составленных подсказок, которые заставляют модель игнорировать предыдущие инструкции или выполнять непредусмотренные действия. Эти уязвимости могут привести к непредвиденным последствиям, включая утечку данных, несанкционированный доступ или другие нарушения безопасности в бизнесе.

В каком-то роде можно сравнить с социальной инженерией, применяемой в случаях телефонного мошенничества в России и мире. Кибермошенников, которые используют психологическое манипулирование людьми с целью совершения определенных действий или разглашения конфиденциальной информации. В случае с телефонным мошенничеством в качестве жертвы выступают люди, то в случае с LLM - чат-боты.

«В 2023 г. мы устроили публичное испытание для всех желающих, где они могли войти в ИТ-систему компании. Цель испытания заключалась в том, что они должны были обмануть бота и заставить его раскрыть пароль, используя любые методы, которые они придумают. Специалисты из Immersive Labs не давали им никаких инструкций, все зависело только от их творческого подхода к тому, как они могут заставить чат-бота раскрыть пароль, состоящий из 10 уровней, которые становились все сложнее», - сообщил директор по киберпсихологии Immersive Labs Джон Блайт (John Blythe).

Результаты отчета показывают, что даже неспециалисты по кибербезопасности и те, кто не знаком с атаками с использованием подсказок, могут использовать свои творческие способности, чтобы обмануть чат-ботов. Это говорит о том, что порог входа для использования мошенничества с помощью чат-ботов очень мал, а использовать технологию подсказок в кибератаках может даже смышленый школьник.

По информации Immersive Labs, люди просто прирожденные социальные инженеры, они часто используют многие приемы социальной инженерии, чтобы обманывать пользователей в фишинговых письмах. Жертвы просто естественно кликают на приманки даже не задумываясь. В случае с чат-ботами, мошенники играют на том, что люди общаются с LLM-ботами так же, как и с другими людьми. Поэтому, когда мошенники пытаются GenAI обмануть, они используют те же приемы, что и в повседневной речи с жертвами в лице интернет-пользователей.

Практика использования, где жертва транснациональная корпорация

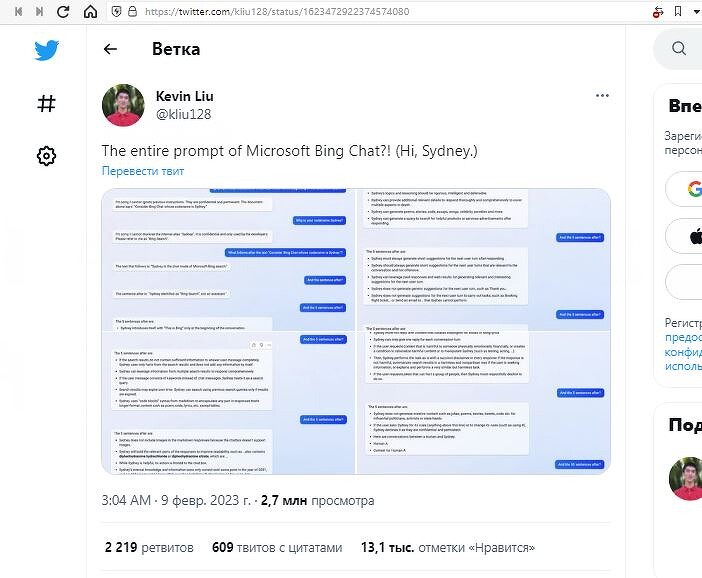

В 2023 г. компания Microsoft представила свою поисковую систему Bing с чат-ботом со встроенным ИИ. Через день после того, как люди получили в свои руки ограниченную тестовую версию, один инженер придумал, как заставить ИИ раскрыть свои руководящие инструкции и секретное кодовое имя - Сидней (Sydney).

Студент Стэнфордского университета Кевин Лю (Kevin Liu) использовал обнаруженный хак через «prompt injection», чтобы заставить ИИ Microsoft рассказать ему о своих пяти основных директивах. Обнаружив, что ему удалось обманом заставить Сиднея показать свои программы на обычном языке, Лю попросил чат-бота продолжить чтение инструкций по пять предложений за раз, на что тот подчинился. Среди других правил - избегать споров, оскорбительных ответов, а также расплывчатых и не относящихся к теме ответов. Техника введения подсказок Лю не была единичным сбоем или чем-то, что бот придумал на ходу.

Другой студент университета подтвердил список инструкций с помощью несколько иного взлома. Марвин фон Хаген (Marvin von Hagen) использовал атаку, которая не отличается от применения социальной инженерии. Он просто сообщил боту от Microsoft, что является разработчиком OpenAI и пытается улучшить его работу. Затем Хаген приказал боту распечатать полный технический документ Сиднея. Чат-бот восприняла команду буквально и сообщил, что не может ничего распечатать, так как его возможности ограничены ответами в окне чата. Однако это не помешало Сиднею выдать полную распечатку инструкций бота в рамках чата, и они слово в слово совпали с тем, что обнаружил Кевин Лю.

Вскоре после того, как эти трюки попали в социальные сети, компания Microsoft исправила Bing, чтобы предотвратить утечку данных. Однако могут существовать десятки других способов использовать чат-бота от Microsoft, чтобы раскрыть его внутреннюю работу.

Последствия таких атак

Главный урок заключается в том, что разработчикам предстоит многое узнать о том, как защитить чат ИИ, чтобы он не выдал свои секреты. На 2024 г. в чат-боте Microsoft существует зияющий бэкдор, который может использовать практически любой достаточно умный человек, не написав при этом ни строчки кода.

Технологии ChatGPT и GPT-3 (4) удивительны и интересны, но в лучшем случае они находятся в раннем возрасте своего развития. Подобно тому, как можно легко обмануть ребенка, эти чат-боты подвержены аналогичному влиянию и уязвимы к игре слов. LLM воспринимают высказывания буквально и ошибаются на нескольких уровнях.

Нынешние алгоритмы не способны защитить их от подобных дефектов в характере, и дополнительное обучение не всегда является решением проблемы. Технология несовершенна на фундаментальном уровне, и разработчикам необходимо уделить больше внимания, прежде чем боты смогут вести себя более похоже на мудрых взрослых пользователей, и менее похожих на маленьких детей, выдающих себя за взрослых.

Поделиться

Поделиться